Introducción

Integrar personajes animados en una escena es un proceso complejo que incluye diferentes fases de trabajo: diseño del personaje y su esqueleto, rigging y -finalmente- animación. En realidad, cada una de estas fases se divide a su vez en otras, requiriendo a menudo diferentes software y especialistas en cada flujo de trabajo. En los estudios de cine digital y de videojuegos existe un departamento dedicado exclusivamente a cada una de estas tareas.

Dentro de la fase de animación, los dos métodos más habitualmente empleados son la animación por keyframes o por captura de movimiento (MOCAP, por sus siglas en inglés). La mayoría de las producciones que podemos ver en el cine, o en las series combinan ambos procedimientos, si bien es cierto que la captura de movimiento permite realizar movimientos complejos en tiempos incomparablemente más cortos respecto a las técnicas más clásicas de animación por keyframes. Así que aquí nos centraremos en ellos. En todo caso este tipo de animaciones (conviene que lo tengamos en cuenta) se producen, se limpian y se editan, no es tan sencillo como realizar el movimiento con nuestro traje y trasladarlo en bruto animación acabada.

En realidad, los sistemas de captura de movimiento llevan entre nosotros décadas, no es algo nuevo en el mercado. Hay diferentes opciones, pero podemos –grosso modo- diferenciarlas en dos grupos:

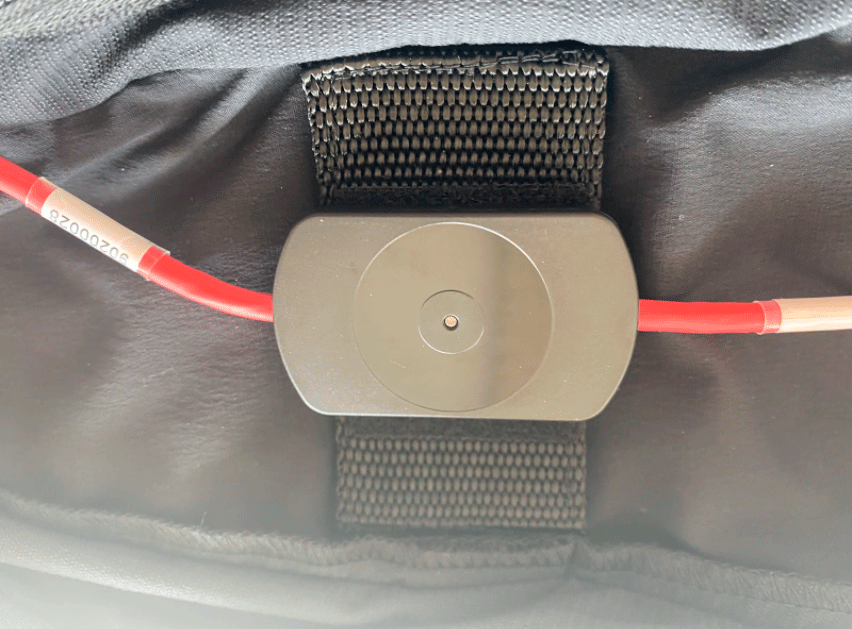

- Sistemas basados en la utilización de dispositivos autónomos dotados de sensores (fig. 1) capaces de transmitir vía inalámbrica su posición y rotación al PC y el software.

- Sistemas que se basan en la utilización de sensores ópticos externos (cámaras) repartidos por un espacio delimitado que determinan la posición del actor (la rastrean o “trackean”), que lleva marcadores colocados en la ropa (habitualmente en forma de esferas). Los principios en los que se basa esta técnica son los mismos que empleamos en fotogrametría digital. De hecho, con una simple cámara digital podemos rastrear la posición de objetos o personas a los que hayamos equipado con marcadores. Si en vez de una única cámara desplegamos varias, evitaremos zonas de sombra y podremos “virtualizar” una escena completa, además de aumentar la precisión gracias a contar con mediciones extra de cada uno de los sensores.

Fig. 1. Uno de los sensores del traje

Utilicemos uno u otro sistema, el resultado final es un archivo que registra información de posición y rotación y que normalmente va acompañado de un esqueleto básico que muestra la ubicación de los diferentes sensores o marcadores rastreados. Para exportar e intercambiar este tipo de información, los formatos más habituales son BVH y FBX.

Es importante tener claro -para evitar lamentos posteriores- qué podemos hacer con estos dispositivos y cuáles son sus limitaciones actuales, que a su vez también varían en función de la tecnología y la marca que hayamos adquirido: lo más importante es tener en cuenta que, a parte de “grabar movimiento”, intervienen otros factores, como la creación del esqueleto y el rigging, que pueden dar problemas, principalmente por la incompatibilidad de algunas estructuras de huesos y blend shapes entre diferentes software. Es habitual que en el intercambio de archivos y animaciones se produzcan cuellos de botella y errores para los que no hay soluciones mágicas, así que toca decantarse por una de las siguientes opciones:

- Aprender técnicas de diseño de personajes, rigging y animación (y hacerlo todo, por ejemplo, en Blender, algo perfectamente posible y compatible… pero complejo, largo y costoso).

- Contratar artistas en las tres disciplinas mencionadas en el punto 1.

- Comprar terceros software que permitan automatizar (o mejor dicho semiautomatizar) estos flujos de trabajo (creación de personajes, rigging y animación). En este sentido, el paquete más habitualmente utilizado en la industria es Realillusion y sus decenas de apps y plugins (principalmente iclone, 3DXchange, CC3+ y demás).

Rokoko

Actualmente existe una amplia oferta de dispositivos MOCAP en el mercado. Desde el primer momento, nosotros hemos tenido claro que necesitábamos un sistema autónomo. ¿Por qué? El motivo es que trabajamos virtualizando yacimientos arqueológicos y monumentos con su propia (y compleja) geometría. Y para recrear los movimientos de personajes dentro de estos espacios no podemos estar limitados a un recinto, por grande que sea. Imaginemos tener que llevar a cabo la recreación virtual de individuos de hace miles de años accediendo a un abrigo para pintar. Lo primero que haremos será realizar un levantamiento 3D del propio abrigo para tener una réplica virtual. Pero cómo haremos para conseguir recrear de un modo realista el acceso y el movimiento de las personas dentro de este espacio? En una sala con cámaras de rastreo nos veremos obligados a simular el suelo y las paredes para poder replicar los mismos movimientos que haríamos en el yacimiento original (y eso será complejo y muy costoso). Con un dispositivo autónomo, podremos desplazarnos hasta el propio abrigo, grabar los movimientos e incluso comprobar los resultados sobre el modelo 3D previamente obtenido. Por lo tanto la elección de un sistema MOCAP autónomo estaba fuera de discusión.

Una vez decidido el tipo de dispositivo tocaba escoger entre la oferta existente en el mercado, desde equipos que superan ampliamente los 10.000 € (software aparte) y garantizan una precisión del movimiento sin errores y evitando interferencias con fuentes de radiación electromagnética, hasta soluciones muy económicas e incluso gratuitas con pocas garantías, escasa integración con blender/maya/3ds max… y soporte / atención al cliente prácticamente inexistente.

Fig. 2. Llegada y unboxing.

Nosotros hemos optado por Rokoko (fig. 2), empresa a la que seguimos desde hace bastante tiempo. Fueron varios los elementos que nos llevaron a inclinarnos por ellos:

- Sistema MOCAP integral (reconocimiento corporal, manual y facial): es importante que el equipo por el que nos decidamos abarque todas la soluciones para evitar tener que utilizar diferentes procesos, software, posibles incompatibilidades…etc. La ventaja de escoger un único fabricante es cómoda, porque garantiza que los sensores que se emplean en el traje sean los mismos (o compatibles) con los que han colocado en los guantes). En este sentido, hasta ahora nuestra experiencia integrando reconocimiento facial y corporal con rokoko ha sido perfecta y esperamos que ocurra lo mismo con los guantes.

- Soporte y atención al cliente: los tiempos de gestión, envíos, resolución de dudas…etc por el momento son muy buenos, algo que evita mucho estrés si nos encontramos en fases de producción avanzadas de proyecto y con deadlines amenazando con ahogarnos!

- Integración en diferentes plataformas: un punto fundamental a la hora de escoger rokoko fue el desarrollo de plugins específicos para blender (aparte de otros software) y motores de juegos (unreal y unity). Afortunadamente, la filosofía de rokoko no ha sido: “toma el traje y búscate la vida”, sino que proporciona las herramientas que facilitan la producción y gestión de aquello que vamos a generar.

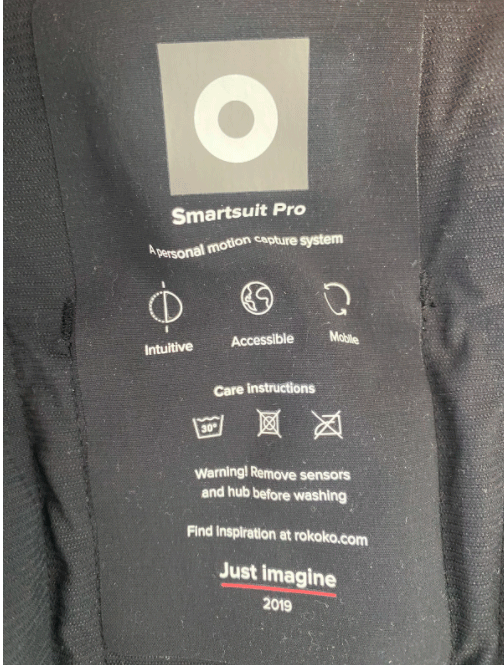

- Calidad del producto: desde que nos llegó el traje el pasado Julio, hemos tenido ocasión de experimentar y familiarizarnos con él. Detrás de una apariencia frágil, el traje resiste perfectamente -teniendo un mínimo de cuidado y sentido común- una utilización bastante intensiva y con diferentes personas. Y sí, después de dos horas con él encima y mil pruebas de movimiento solo estás deseando quitártelo, pero la tela es microperforada y en ningún momento es una sensación agobiante, al menos desde nuestra experiencia. Es muy recomendable ayudarse de otra persona para ponérselo y quitárselo correctamente y sin desgarrar el tejido. Por supuesto, el traje se puede lavar, aunque lógicamente primero hay que retirar todos los sensores y cables que los unen… para luego volver a colocarlos (fig. 3). Es un proceso un poco tedioso, pero que no lleva más de 10 minutos en total.

- Precio: cualquiera puede consultar los precios en la web del fabricante, así que no es necesario repetirlos aquí. Siempre es complicado emitir un juicio sobre lo que es caro o lo que es barato, supongo que depende de muchas cosas, hay diferentes variables a tener en cuenta: recursos disponibles y financiación, perspectivas de amortización, potencial, inversión, riesgo, comparación con otras opciones disponibles en el mercado… cada uno debe sopesar cuidadosamente todos y cada uno de estos puntos antes de lanzarse a ello. Exactamente igual que a la hora de decidirse por la compra de un PC o actualizarlo con una gráfica o un procesador más potentes.

Fig. 3. Especificaciones para el lavado

En todo caso, es importante tener en cuenta que el hardware (traje, guantes) van por un lado y es solo una parte del equipo necesario. Luego está la licencia de software desde el que gestionamos, editamos y exportamos la animación. Esta licencia es renovable anualmente, algo por otro lado similar al del resto de opciones que hay disponibles actualmente, nada nuevo.

En este apartado del precio y para concluir, pensamos que se sitúa como una buena opción para pequeños estudios o profesionales autónomos, con una excelente calidad de resultados por un precio razonable (fig. 4).

Fig. 4. Smartsuit pro

Primeros pasos!

Y ahora vamos con los primeros pasos que hemos podido dar con el traje. La COVID no respeta ni la captura de movimiento, por lo que las pruebas han tenido que ser caseras XD

En el primer vídeo tenemos una prueba inicial básica con un personaje descargado de la librería de personajes y movimientos de Mixamo que solemos enseñar (junto con Adobe Fuse) en las clases del máster para agregar personajes a nuestra escena. Nuestra compañera Laia hace de actriz y todo el proceso se resume en unos pocos y sencillos pasos:

- Iniciamos sesión en rokoko studio.

- Conectamos el traje al PC y lo configuramos dentro del propio software, con opciones relativas a la conexión wifi, la creación de un perfil corporal para aumentar la precisión de los movimientos y aceptamos.

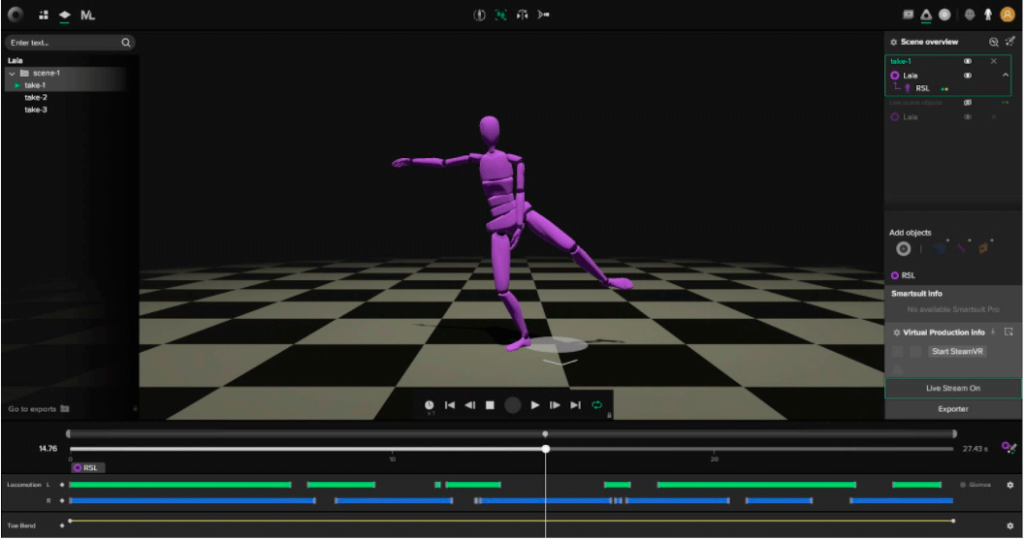

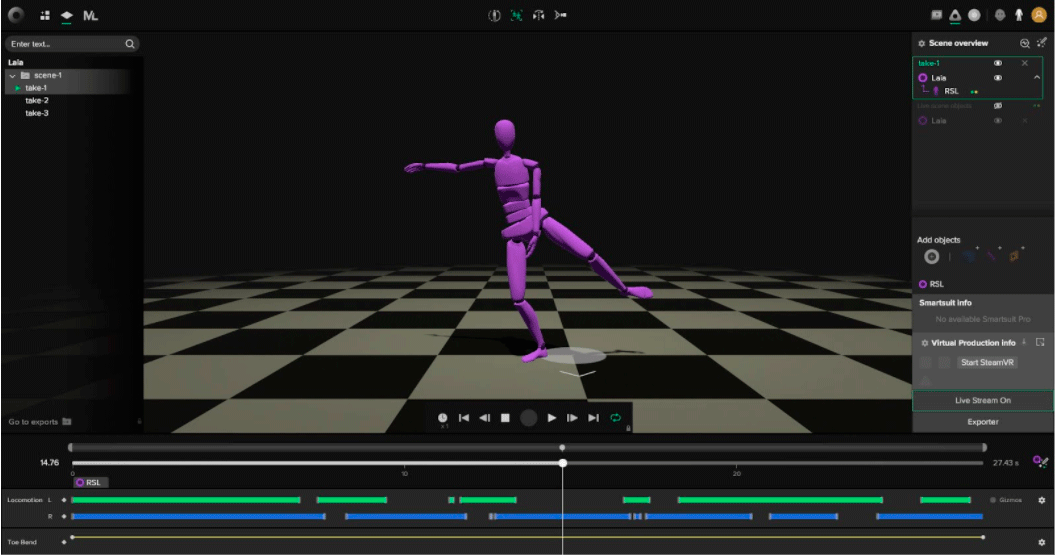

- La interfaz del software (fig. 5) está en gran parte ocupada por un visor 3D donde se lleva a cabo la animación y en el que podemos ver nuestro avatar en tiempo real. A la derecha tenemos un outliner en el que podemos ver enumerados y jerarquizados los elementos con los que estamos trabajando, pudiendo arrastrarlos y emparentarlos (trajes, guantes, captura facial, objetos traqueados). Y a la izquierda un organizador de la escena y las acciones que vamos llevando a cabo. Desde el menú superior tenemos las opciones clásicas de guardado, importación / exportación…etc.

Fig. 5. Interfaz de Rokoko Studio

- Una vez que el software ha reconocido el traje, necesitamos (por este orden): conectarle una batería portátil, de las que solemos usar para llevarnos a la montaña y poder recargar el móvil. Y entonces podemos desconectar el cable de conexión al PC.

- Arrastramos el traje smartsuit pro al perfil corporal (en este caso el de Laia) en el outliner para emparentarlo.

- Y ahora vamos a grabar nuestro primer movimiento. Pulsamos antes en el icono de calibración, nos estamos quietos en la posición que nos indica durante unos 5 segundos y… ahora sí! A moverse! Eso sí… tened cuidado de por dónde os movéis, intentad manteneros alejados un par de metros de aparatos que emitan radiación electromagnética, porque deteriorará la calidad y precisión de la señal que llegue desde los sensores del traje hasta el PC y el software. Algo que es más sencillo evitar si estáis en un espacio al aire libre. En este segundo caso recordad que tendréis que configurar una red wifi entre vuestro PC o portátil, el smartphone para el reconocimiento facial y el propio smartsuit pro.

- Muchos ya os habréis dado cuenta de que lo que estamos viendo en el vídeo es la interfaz de nuestro querido Blender. Y como en este post ya nos hemos alargado demasiado XD, lo explicaremos con más calma en el próximo post, pero por ahora basta con decir que, gracias al plugin de rokoko para Blender, no solo podemos importar el archivo con nuestra animación y adaptarlo a un personaje que hayamos descargado o modelado, sino que además podemos transmitir en vivo desde rokoko studio a Blender, pudiendo previsualizar en tiempo real los resultados de nuestra captura de movimiento. En el segundo vídeo podéis los mismos resultados, pero en este caso con reconocimiento facial integrado y utilizando el personaje ya riggeado del mimo que puedes descargar desde rokoko para probar.

A falta de seguir trabajando, probando, practicando y afinando… esto es todo por ahora! Volvemos pronto con los próximos avances y (cruzamos los dedos) ya con los guantes puestos! 😉

Deja tu comentario